KI-Tools wie ChatGPT, Claude, Gemini oder Mistral verstehen beispielsweise nicht, was Schwerkraft bedeutet, in welcher räumlichen Beziehung Objekte zueinander stehen oder wie man sich in einem Raum bewegen kann. Sie kennen nur zwei Dimensionen und müssen die 3D-Welt, in der wir Menschen leben, erst noch begreifen lernen.

Was ist Spatial Intelligence?

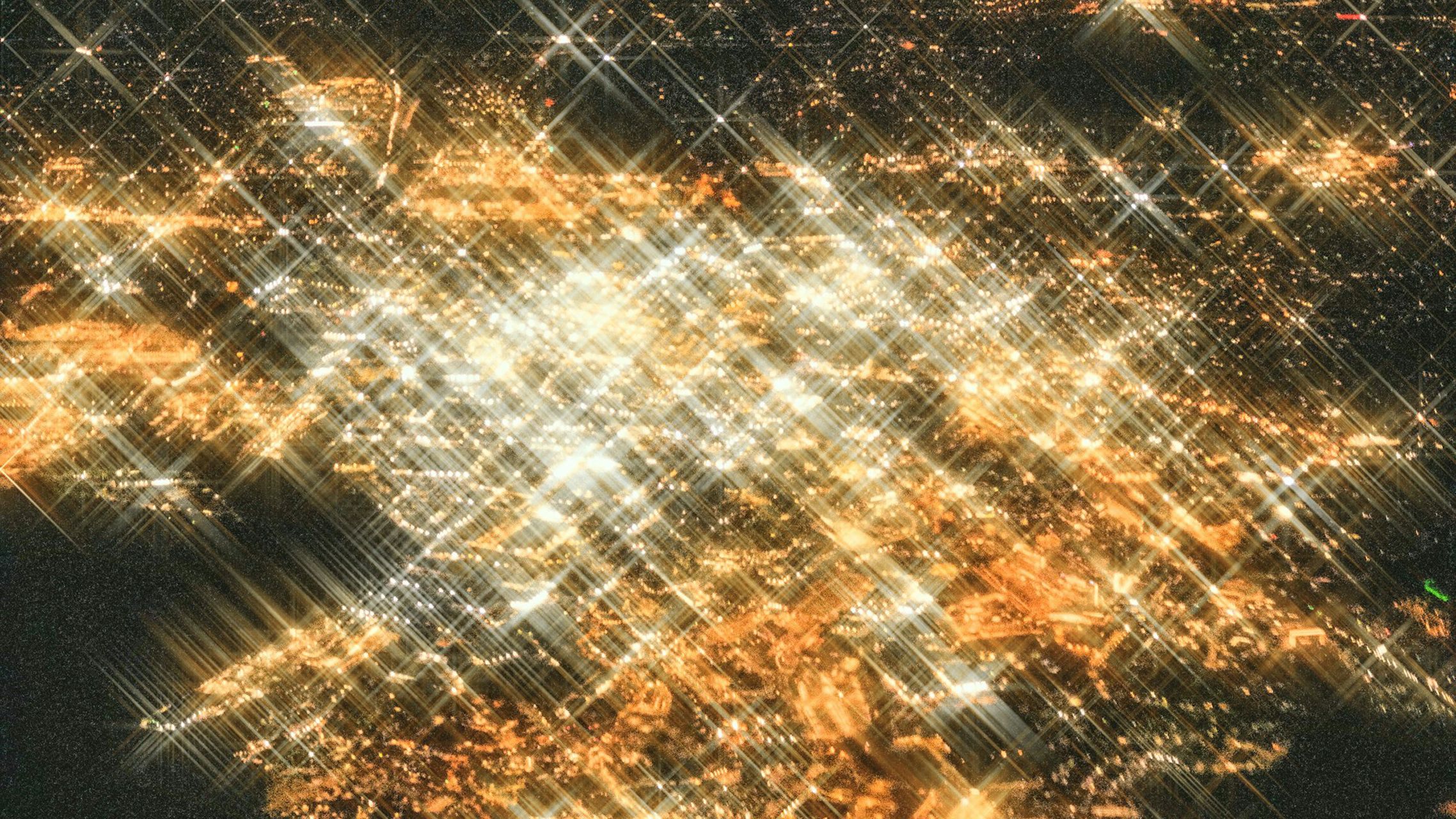

Dieser wichtige Evolutionsschritt, den die KI noch gehen muss, nennt sich „Spatial Intelligence“ oder „Räumliche Intelligenz“. Damit ist die Fähigkeit von KI-Systemen gemeint, dreidimensionale Räume mit all ihren physikalischen Gesetzen zu verstehen, in ihnen zu navigieren und mit ihnen zu interagieren.

Um diesen Entwicklungsschritt zu ermöglichen, muss zunächst die Datenbasis erweitert werden. Während bekannte Large Language Models (LLM) wie ChatGPT mit Texten trainiert wurden, benötigt Spatial Intelligence auch Informationen, die ein umfassendes Verständnis der physikalischen Welt ermöglichen. KI-Entwickler sprechen daher auch von „Large World Models“ (LWM).

Bildlich gesprochen sollen sie nicht nur Objekte wie einen Ball und eine Feder erkennen und voneinander unterscheiden können, sondern auch verstehen, wie sie sich aufgrund ihrer physikalischen Merkmale in einem Raum verhalten. Während es für einen erwachsenen Menschen vollkommen logisch ist, dass ein Ball schneller zu Boden fällt als eine Feder, wenn man sie fallenlässt, muss sich die KI diese Logik über das neue LWM erst antrainieren.

Technisch betrachtet basiert Spatial Intelligence auf der Fusion verschiedener Datenquellen, darunter Kamerasysteme, Lidar-Sensoren, Radar und andere räumliche Sensoren. Wem das jetzt bekannt vorkommt: Diese Sensor-Systeme spielen bereits eine wichtige Rolle. Und zwar bei der Entwicklung von autonomen Fahrzeugen. Auch hier geht es darum, den Fahrsystemen einen möglichst umfassenden Blick auf die Umwelt zu ermöglichen. Man könnte auch sagen: Autos sollen lernen, ähnlich wie Menschen zu sehen.